Simon Willison เพิ่งเปิดตัวปลั๊กอินใหม่ชื่อ llm-hacker-news สำหรับเครื่องมือ LLM แบบคอมมานด์ไลน์ของเขา ซึ่งออกแบบมาเพื่อดึงเนื้อหาจากการสนทนาบน Hacker News และป้อนเข้าสู่โมเดลภาษาขนาดใหญ่โดยตรง แม้ว่าความสำเร็จทางเทคนิคนี้จะสร้างความประทับใจให้กับหลายคน แต่ก็จุดประเด็นการถกเถียงที่สำคัญเกี่ยวกับความเป็นส่วนตัวของข้อมูล การยินยอม และจริยธรรมของการใช้เนื้อหาจากฟอรัมสาธารณะสำหรับการประมวลผล AI

นวัตกรรมทางเทคนิค

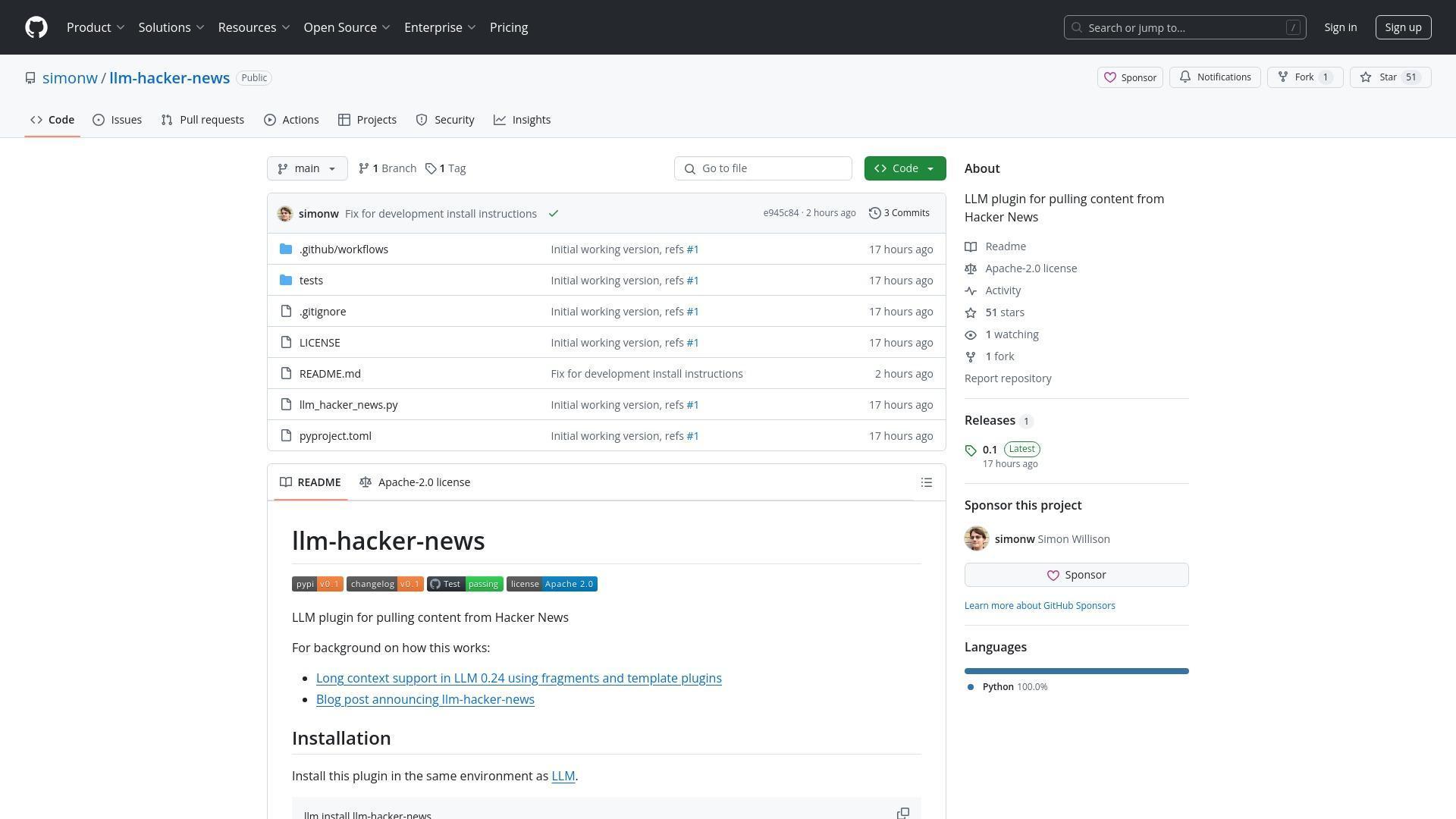

ปลั๊กอิน llm-hacker-news พัฒนาต่อยอดจากฟีเจอร์ fragments ที่ Willison เพิ่มเข้าไปในเครื่องมือคอมมานด์ไลน์ LLM ของเขา ฟีเจอร์นี้ช่วยให้ผู้ใช้สามารถป้อนเนื้อหาบริบทยาวเข้าสู่โมเดลภาษาขนาดใหญ่อย่าง Gemini และ Llama 4 ได้อย่างง่ายดาย ปลั๊กอินนี้ช่วยให้ผู้ใช้สามารถดึงข้อมูลเธรดการสนทนาทั้งหมดจาก Hacker News โดยใช้ไวยากรณ์คำสั่งอย่างง่าย:

llm -f hn:43615912 'summary with illustrative direct quotes'

ปลั๊กอินนี้จะดึงข้อมูลจาก API ของ Hacker News แปลงเป็นรูปแบบข้อความที่เป็นมิตรกับ LLM และส่งไปยังโมเดลเริ่มต้นที่ผู้ใช้กำหนดไว้ (เช่น gpt-4o-mini) ซึ่งช่วยลดขั้นตอนในการวิเคราะห์และสรุปการสนทนาออนไลน์โดยไม่ต้องคัดลอกและวางด้วยตนเอง

คุณสมบัติหลักของปลั๊กอิน llm-hacker-news:

- อนุญาตให้ดึงข้อมูลเธรดทั้งหมดของ Hacker News โดยใช้ไอดีรายการ

- สร้างขึ้นบนฟีเจอร์ "fragments" ใหม่ในเครื่องมือคำสั่ง LLM

- ใช้ Algolia JSON API เพื่อดึงเนื้อหา

- แปลงเนื้อหาของ HN ให้เป็นรูปแบบข้อความที่เป็นมิตรกับ LLM

- ทำงานร่วมกับโมเดล LLM หลากหลาย รวมถึง GPT-4o-mini, Claude และ Gemini

การติดตั้งและการใช้งาน:

llm install llm-hacker-news

llm -f hn:43615912 'summary with illustrative direct quotes'

ความกังวลของชุมชนที่เกี่ยวข้อง:

- ความเป็นส่วนตัวของข้อมูลและการยินยอมสำหรับการประมวลผลเนื้อหา

- การปฏิบัติตามข้อกำหนดการใช้บริการ

- ความแตกต่างระหว่างการอ่านโดยมนุษย์กับการประมวลผลด้วยอัลกอริทึม

- อนาคตของความเป็นเจ้าของเนื้อหาในอินเทอร์เน็ตที่ขับเคลื่อนด้วย AI

ข้อกังวลเรื่องความเป็นส่วนตัวและการยินยอม

การเปิดตัวนี้ได้จุดประเด็นการถกเถียงอย่างรุนแรงเกี่ยวกับว่าผู้ใช้ควรสามารถเลือกที่จะไม่ให้โพสต์ในฟอรัมของพวกเขาถูกประมวลผลโดย LLM หรือไม่ ผู้ใช้รายหนึ่งถามตรงๆ ว่า: มีวิธีที่จะเลือกไม่ให้บทสนทนาของฉันถูกส่งเข้า LLM หรือไม่? คำถามนี้สะท้อนความกังวลที่เพิ่มขึ้นเกี่ยวกับการเก็บข้อมูลเนื้อหาและสิทธิ์การใช้งาน

ความกังวลตรงนี้คือผู้คนไม่พอใจที่พวกปรสิต LLM กำลังสูญเสียแบนด์วิดธ์และเงินของพวกเขาไปกับแผนการที่จะรวยจากผลงานของคนอื่น

Willison ตอบโดยชี้ให้เห็นถึงความเป็นไปไม่ได้ในทางปฏิบัติที่จะป้องกันการคัดลอกและวาง โดยระบุว่าแม้จะมีข้อจำกัดดังกล่าว การถ่ายภาพหน้าจอก็สามารถหลีกเลี่ยงได้ เขายังเน้นย้ำถึงภูมิทัศน์ที่ซับซ้อนของนโยบายการฝึกฝน LLM ที่ผู้ให้บริการบางรายเช่น OpenAI และ Anthropic ไม่ได้ฝึกฝนบนเนื้อหาที่ส่งผ่าน API ในขณะที่รายอื่นๆ เช่น Gemini อาจใช้ข้อมูลจากผู้ใช้ระดับฟรีเพื่อปรับปรุงผลิตภัณฑ์

ขอบเขตทางกฎหมายและจริยธรรม

ผู้แสดงความคิดเห็นหลายคนตั้งคำถามว่าปลั๊กอินนี้ละเมิดข้อกำหนดการใช้งานของ Hacker News หรือไม่ ซึ่งห้ามการเก็บข้อมูลและการรวบรวมข้อมูล ผู้ใช้รายหนึ่งอ้างถึงแนวทางของ HN โดยเฉพาะ: ยกเว้นที่ได้รับอนุญาตอย่างชัดเจนจาก Y Combinator คุณตกลงที่จะไม่ดัดแปลง คัดลอก จัดกรอบ เก็บข้อมูล [...] หรือสร้างงานดัดแปลงโดยอิงจากไซต์หรือเนื้อหาของไซต์

การสนทนาเผยให้เห็นความตึงเครียดพื้นฐานระหว่างการเข้าถึงสาธารณะและความเป็นเจ้าของเนื้อหา ในขณะที่บางคนโต้แย้งว่าการโพสต์บนฟอรัมสาธารณะเป็นการยินยอมโดยนัยให้มีการบริโภคในรูปแบบต่างๆ คนอื่นๆ ยืนยันว่ามีความแตกต่างที่มีความหมายระหว่างการอ่านของมนุษย์และการประมวลผลด้วยอัลกอริทึม โดยเฉพาะอย่างยิ่งเมื่อการประมวลผลนั้นอาจจะกลายเป็นส่วนหนึ่งของชุดข้อมูลฝึกฝน AI เชิงพาณิชย์ในที่สุด

อนาคตของเครื่องมือ LLM

แม้จะมีข้อถกเถียง ผู้ใช้หลายคนแสดงความสนใจในศักยภาพของเทคโนโลยีนี้ คำขอสำหรับฟังก์ชันการทำงานที่ขยายเพิ่มเติมรวมถึงการสรุปหัวข้อโปรดบน HN การติดตามการสนทนาตลอดเวลา และการบูรณาการกับโปรโตคอลอื่นๆ เช่น MCP (Message Context Protocol) Willison กล่าวว่าฟีเจอร์ LLM ที่สำคัญถัดไปของเขาจะเป็นการสนับสนุนเครื่องมือ โดยมีแผนที่จะสร้างปลั๊กอิน MCP บนกรอบการทำงานนั้น

การสนทนายังเกี่ยวข้องกับคุณภาพที่ปรับปรุงอย่างรวดเร็วของโมเดล LLM ในเครื่อง Willison สังเกตว่าโมเดลในเครื่องส่วนใหญ่มีความสามารถต่ำจนใช้งานไม่ได้จนกระทั่งเมื่อประมาณหกเดือนที่ผ่านมา แต่เมื่อไม่นานมานี้ได้กลายเป็นโมเดลที่มีความสามารถมากขึ้น โดยโมเดลเช่น Qwen Coder 2.5, Llama 3.3 70B, Mistral Small 3 และ Gemma 3 ตอนนี้ทำงานได้อย่างน่าประทับใจบนฮาร์ดแวร์ของผู้บริโภคที่มี RAM เพียงพอ

ปลั๊กอิน llm-hacker-news แสดงถึงทั้งความเป็นไปได้ทางเทคนิคที่น่าตื่นเต้นและคำถามทางจริยธรรมที่ซับซ้อนที่เกิดขึ้นเมื่อเครื่องมือ AI กลายเป็นส่วนหนึ่งของประสบการณ์ออนไลน์ของเรามากขึ้น เมื่อเทคโนโลยีเหล่านี้ยังคงพัฒนาต่อไป ชุมชนจะต้องค้นหาความสมดุลระหว่างนวัตกรรมและการเคารพการกระทำของผู้ใช้และสิทธิ์ในเนื้อหา

อ้างอิง: Ilm-hacker-news