การพัฒนาระบบ OCR (Optical Character Recognition) เฉพาะทางสำหรับการเรียนรู้ของเครื่อง (Machine Learning) ได้จุดประกายการถกเถียงสำคัญเกี่ยวกับความน่าเชื่อถือของ AI ความถูกต้องของข้อมูล และข้อพิจารณาด้านจริยธรรม ระบบ OCR ที่ได้มีการแบ่งปันล่าสุดซึ่งออกแบบมาโดยเฉพาะสำหรับการดึงข้อมูลเชิงโครงสร้างจากเอกสารการศึกษาที่ซับซ้อน ได้กลายเป็นศูนย์กลางของการสนทนาที่มีความละเอียดอ่อนในชุมชนเกี่ยวกับประโยชน์และความเสี่ยงของการใช้ AI แบบสร้างข้อมูล (generative AI) ในกระบวนการประมวลผลเอกสาร

|

|---|

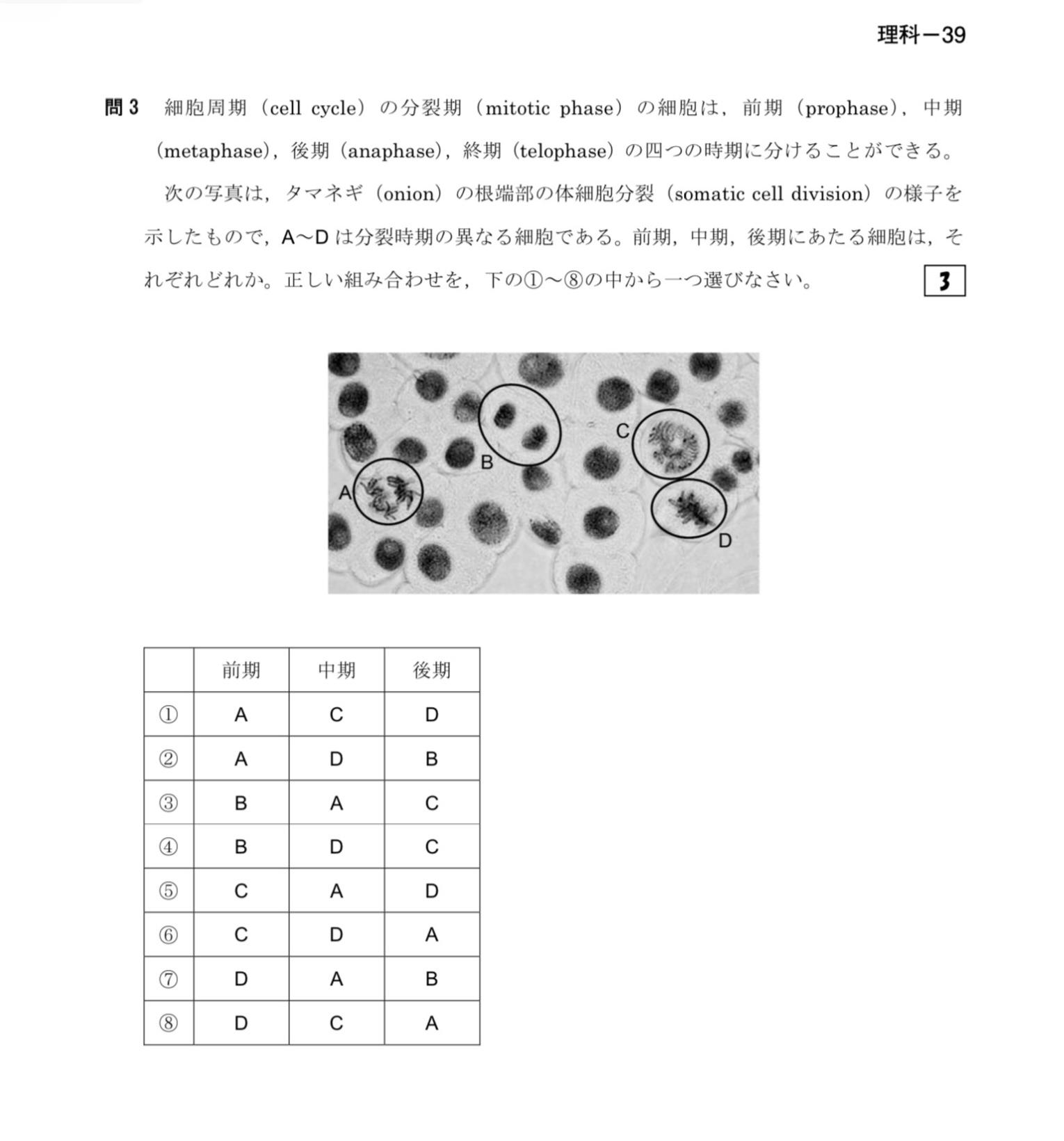

| ภาพประกอบนี้อธิบายขั้นตอนของการแบ่งเซลล์แบบไมโทซิสในเซลล์พืช เน้นย้ำถึงความสำคัญของการสกัดข้อมูลแบบมีโครงสร้างในสื่อการเรียนการสอน |

ความกังวลเรื่องการสร้างข้อมูลเท็จกับ OCR ที่เสริมด้วย AI

สมาชิกในชุมชนได้แสดงความกังวลอย่างมีนัยสำคัญเกี่ยวกับความน่าเชื่อถือของการใช้โมเดลภาษาขนาดใหญ่ (Large Language Models หรือ LLMs) ในกระบวนการ OCR ความกังวลหลักมุ่งเน้นไปที่การสร้างข้อมูลเท็จของ AI - ซึ่งโมเดลอาจไม่เพียงแค่แก้ไขข้อผิดพลาดจาก OCR เท่านั้น แต่ยังอาจเปลี่ยนแปลงเนื้อหาที่ถูกต้องโดยไม่ตั้งใจหรือสร้างข้อมูลที่เป็นเท็จทั้งหมด ผู้แสดงความคิดเห็นคนหนึ่งเปรียบเทียบความเสี่ยงนี้กับ xerox bug on steroids โดยอ้างอิงถึงปัญหาในอดีตที่เอกสารที่สแกนมีตัวเลขสลับกันโดยไม่ได้ตั้งใจ แต่อาจมีผลกระทบรุนแรงมากขึ้นเมื่อมี AI เข้ามาเกี่ยวข้อง

นักพัฒนาได้รับทราบความกังวลเหล่านี้ โดยระบุว่าพวกเขาได้ใช้วิธีการแบบสองขั้นตอน โดยให้เครื่องมือ OCR แบบดั้งเดิมจัดการการดึงข้อความในขั้นตอนแรก และใช้ AI แบบสร้างข้อมูลเฉพาะในขั้นตอนที่สองเพื่อปรับแต่งเท่านั้น พวกเขายังกล่าวถึงการใช้การตรวจสอบความถูกต้องอย่างง่ายเพื่อป้องกันการเปลี่ยนแปลงข้อความที่ดึงมาได้อย่างถูกต้องแล้ว แม้ว่าประสิทธิภาพของมาตรการป้องกันเหล่านี้ยังคงต้องได้รับการประเมินอย่างละเอียด

องค์ประกอบหลักของระบบ OCR

- DocLayout-YOLO: สำหรับการตรวจจับพื้นที่ตาราง

- Google Vision API: ใช้สำหรับการประมวลผลตารางและการวิเคราะห์ภาพ

- Gemini Pro Vision: สำหรับการสร้างคำอธิบายที่คำนึงถึงบริบท

- MathPix OCR: สำหรับการแยกสูตรคณิตศาสตร์

- OpenCV: สำหรับการประมวลผลภาพ

ข้อกังวลหลักของชุมชน

- ความเสี่ยงจากการประดิษฐ์ข้อมูลเท็จของ AI เมื่อใช้ LLMs สำหรับ OCR

- ช่องโหว่จากการฉีด prompt

- ความขัดแย้งด้านใบอนุญาต (MIT กับ AGPL-3.0)

- การได้มาซึ่งข้อมูลอย่างมีจริยธรรมเพื่อการฝึกฝน

- ความเป็นของแท้ในการสื่อสารที่ AI ช่วยเหลือ

การปรับปรุงในอนาคตที่วางแผนไว้

- รองรับการอนุมานแบบเต็มรูปแบบในเครื่องโดยไม่ต้องพึ่งพา API

- องค์ประกอบโอเพนซอร์สทางเลือก:

- Tesseract หรือ TrOCR สำหรับ OCR ทั่วไป

- Pix2Struct, Donut, หรือ DocTR สำหรับโครงสร้างเอกสาร

- OpenAI CLIP สำหรับการจัดตำแหน่งความหมายระหว่างภาพกับข้อความ

- Gemma / Phi / LLaMA / Mistral สำหรับงานด้านการให้เหตุผล

- โมดูลการจัดโครงสร้างความหมายที่ได้รับการปรับปรุง

ช่องโหว่การฉีด Prompt (Prompt Injection)

ผู้แสดงความคิดเห็นที่มีความรู้ด้านความปลอดภัยได้เน้นย้ำว่าการฉีด prompt เป็นอีกหนึ่งพื้นที่ความเสี่ยงที่อาจเกิดขึ้น เมื่อ LLMs เป็นส่วนหนึ่งของกระบวนการประมวลผล จึงมีความท้าทายโดยธรรมชาติในการรักษาการแบ่งแยกที่ชัดเจนระหว่างคำสั่งและข้อมูลที่กำลังประมวลผล สิ่งนี้อาจทำให้เนื้อหาที่เป็นอันตรายในเอกสารสามารถควบคุมพฤติกรรมของระบบได้

นักพัฒนาตอบว่าพวกเขากำลังพยายามลดความเสี่ยงนี้โดยใช้การจัดรูปแบบ JSON เพื่อแยกคำสั่งออกจากข้อมูลและเรียกใช้ระบบในสภาพแวดล้อมแบบ sandbox อย่างไรก็ตาม พวกเขายอมรับว่าวิธีนี้ยังไม่สมบูรณ์แบบ ซึ่งบ่งชี้ว่าความกังวลด้านความปลอดภัยยังคงเป็นพื้นที่ที่ต้องปรับปรุงอย่างต่อเนื่อง

คำถามเกี่ยวกับโอเพนซอร์สและการอนุญาต

โครงสร้างการอนุญาตของโครงการนี้ก็ถูกตรวจสอบอย่างละเอียดเช่นกัน แม้ว่าในตอนแรกจะเผยแพร่ภายใต้ใบอนุญาต MIT แต่สมาชิกในชุมชนได้ชี้ให้เห็นถึงความไม่เข้ากันที่อาจเกิดขึ้นกับองค์ประกอบบางอย่างที่รวมอยู่ - โดยเฉพาะโมเดล DocLayout-YOLO ซึ่งใช้ใบอนุญาต AGPL-3.0 ที่มีข้อจำกัดมากกว่า สิ่งนี้เน้นย้ำถึงภูมิทัศน์การอนุญาตที่ซับซ้อนที่ระบบไฮบริด AI ต้องเผชิญ โดยเฉพาะเมื่อรวมองค์ประกอบโอเพนซอร์สหลายรายการที่มีข้อกำหนดแตกต่างกัน

นักพัฒนาดูเหมือนจะประหลาดใจกับความขัดแย้งด้านการอนุญาตนี้ โดยยอมรับข้อผิดพลาดทันทีและให้คำมั่นว่าจะตรวจสอบข้อกำหนดการอนุญาตอย่างรอบคอบมากขึ้น - แสดงให้เห็นถึงความท้าทายที่นักพัฒนาต้องเผชิญในการจัดการด้านกฎหมายของการพัฒนาระบบ AI อย่างเหมาะสม

การแปลภาษาและความท้าทายในการสื่อสาร

มีการถกเถียงที่น่าสนใจเกิดขึ้นเกี่ยวกับการที่นักพัฒนาใช้ LLMs เพื่อช่วยในการร่างคำตอบต่อความคิดเห็นของชุมชน เมื่อถูกถามเกี่ยวกับรูปแบบการเขียนที่ดูเป็นทางการอย่างน่าสงสัย นักพัฒนาเปิดเผยว่าพวกเขาเป็นนักศึกษาชาวเกาหลีอายุ 19 ปีที่ใช้ความช่วยเหลือจาก AI เพื่อสื่อสารในภาษาอังกฤษได้ชัดเจนยิ่งขึ้น สิ่งนี้จุดประกายการสนทนาที่กว้างขึ้นเกี่ยวกับความชอบธรรมของการใช้ AI เป็นเครื่องมือช่วยในการสื่อสารเทียบกับการรักษาการแสดงออกส่วนบุคคลที่แท้จริง

สมาชิกบางคนในชุมชนสนับสนุนกรณีการใช้งานนี้ว่าเป็นเรื่องที่สมเหตุสมผล - โดยเปรียบเทียบกับการใช้แป้นพิมพ์หรือตัวตรวจการสะกดคำเพื่อเพิ่มประสิทธิภาพการสื่อสาร - ในขณะที่คนอื่นๆ แสดงความกังวลเกี่ยวกับการทำให้การสนทนาออนไลน์เป็นแบบเดียวกันมากขึ้นผ่านการสื่อสารที่มี AI เป็นตัวกลาง

ทิศทางในอนาคตสำหรับ OCR ในการเรียนรู้ของเครื่อง

แม้จะมีความกังวล ผู้แสดงความคิดเห็นหลายคนตระหนักถึงคุณค่าของเป้าหมายหลักของโครงการ: การปรับปรุงคุณภาพของข้อมูลสำหรับการฝึกฝนการเรียนรู้ของเครื่องโดยการดึงข้อมูลเชิงโครงสร้างจากเอกสารที่ซับซ้อน ผู้แสดงความคิดเห็นคนหนึ่งเน้นย้ำว่าการจัดระเบียบข้อมูลที่ดึงมาให้เป็นโครงสร้างที่มีความหมายทางความหมายที่สอดคล้องกันเป็นสิ่งสำคัญสำหรับการฝึกฝน ML คุณภาพสูง ซึ่งบ่งชี้ว่าการจัดโครงสร้างทางความหมายนอกเหนือจากการวิเคราะห์เค้าโครงพื้นฐานเป็นพรมแดนถัดไปสำหรับการเพิ่มมูลค่าข้อมูล OCR สูงสุดในกระบวนการฝึกฝน ML

นักพัฒนาได้แสดงแผนที่จะขยายความสามารถของระบบในทิศทางนี้ โดยเพิ่มโมดูลสำหรับการสร้างการแสดงแบบลำดับชั้นและการระบุความสัมพันธ์ของเอนทิตีระหว่างส่วนต่างๆ ของเอกสาร

เมื่อ AI ถูกผสานเข้ากับกระบวนการประมวลผลเอกสารอย่างต่อเนื่อง การสนทนาของชุมชนเกี่ยวกับระบบ OCR นี้เน้นย้ำถึงความสมดุลที่ละเอียดอ่อนที่นักพัฒนาต้องรักษาระหว่างการใช้ประโยชน์จากความสามารถของ AI และการจัดการกับความกังวลที่ชอบธรรมเกี่ยวกับความถูกต้องของข้อมูล ความปลอดภัย และการใช้งานอย่างมีจริยธรรม การสนทนาแสดงให้เห็นว่าการแบ่งปันเครื่องมือ AI อย่างเปิดเผยสามารถนำไปสู่ข้อเสนอแนะจากชุมชนที่มีคุณค่าซึ่งในท้ายที่สุดจะปรับปรุงเทคโนโลยีให้ดีขึ้นสำหรับทุกคน

อ้างอิง: OCR System Optimized for Machine Learning: Figures, Diagrams, Tables, Math & Multilingual Text

|

|---|

| การนำเสนอข้อมูลภาพที่มีโครงสร้างเป็นสิ่งสำคัญในการปรับปรุงคุณภาพของข้อมูลสำหรับการฝึกฝน machine learning |